Adam优化器

一种改进版的梯度下降gradient descent算法,结合了两种经典优化器的优点:

动量法Momentum:加速收敛,减少震荡

RMSProp优化器:根据每个参数的历史梯度调整学习率

Adam能够自动调整每个参数的学习率,还能够利用过去的梯度“记忆”加速优化,使它比普通的梯度下降收敛得更快、更稳。

核心思想

Adam更新参数时,同时考虑:

Adam一阶矩(均值估计)

本质:历史梯度的滑动平均

作用:让更新过程更平滑,不被当前的单个大梯度扰动

Adam二阶矩(方差估计)

本质:记录梯度的方差,用来给大梯度方向调小步长

作用:在震荡大的方向上放慢步长,避免发散

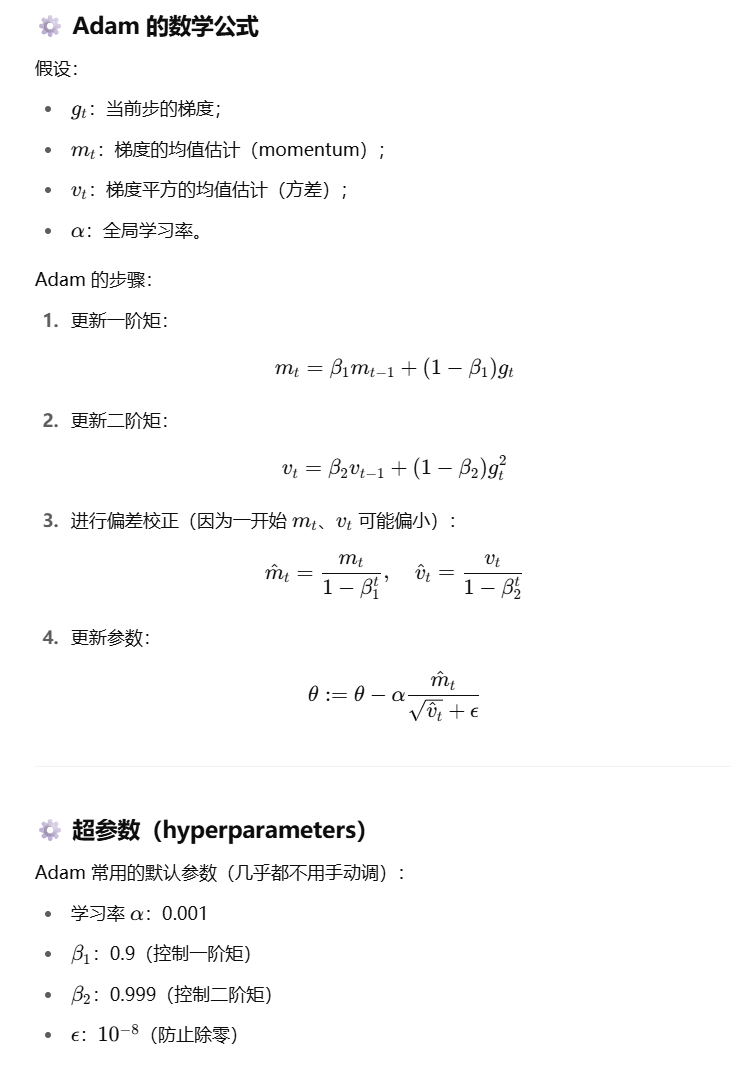

数学公式

优点

可以自动调整参数学习率、收敛速度快、对于稀疏梯度/非平稳目标效果好、几乎不用复杂调参

缺点

在某些任务上可能会过拟合(过拟合vs欠拟合#过拟合)

有时候不如SGD+学习率衰减找到更好的最终泛化能力